どうも、しもつきです。今回は論文紹介をしてみたいと思います。

紹介するのは、タイトルにもあります「Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data」という論文です。

今年になってから巷を大変賑わしている論文で、今年(2024年)のCVPRにも採択された、単眼デプス推定の論文ですね。

以下は、この論文のプロジェクトページになりますので、論文やコード、結果などなどに興味があるかたは是非ご覧になってください。

前置きはここまでにしておいて、それでは以下よりどうぞ。

どういう論文なの?

ざっくり言うと「あらゆる画像に対して、あらゆる状況下で機能する単純ながら強力な基盤モデルを構築することを目指した単眼デプス手法」を提案した論文です。

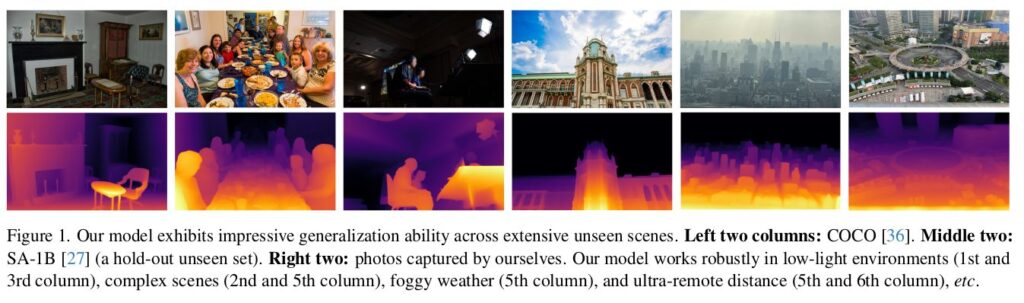

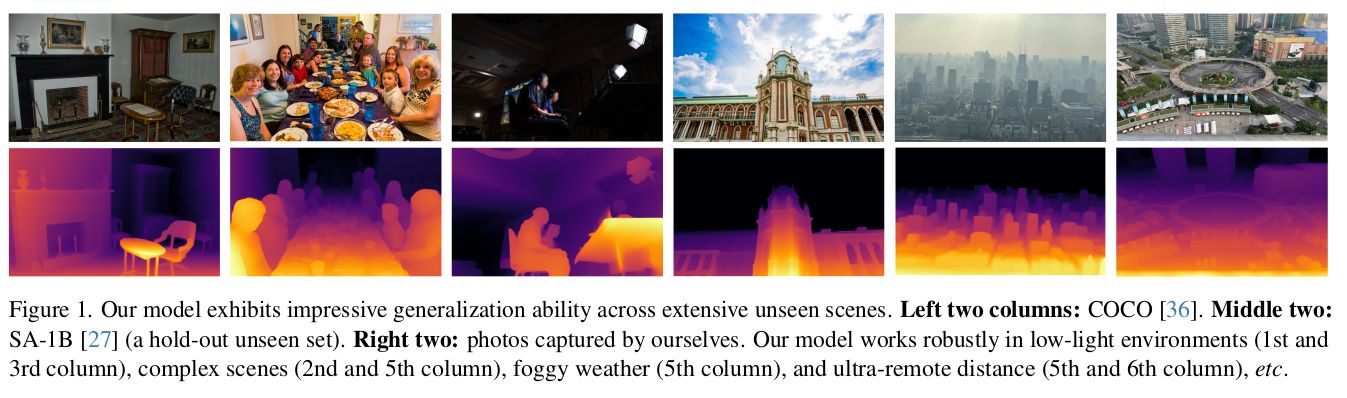

この主要な結果がわかる論文の図1を引用して以下に貼りますが、いずれの画像でも非常にうまくデプスが推定できているように見受けられます。

個人的には、左から3番目の画像は照明条件的に厳しいながらも、かなりそれらしいデプスを吐けていて素晴らしいと思います。

これまでの研究と比べて、何がすごいの?

これまでの研究と比べて、この論文の特筆すべき点は「大規模なラベルなしデータを活用して、あらゆる画像の単眼デプス推定の能力を大幅に向上させたこと」です。

具体的には、ラベルなしの大規模データを利用することでAIが学習すべき多様なシナリオや状況を広範囲にわたってカバーしており、従来よりもはるかに多くの場面や条件を反映したデータセットを作成しています。結果、学習したモデルは、さまざまな新しい環境や未知のシーンに対してもより正確な推定能力を獲得しました。

また、モデルの一般化能力と堅牢性を向上させるために、データ拡張においても以下のような工夫をしています。

- 対象の画像特徴をより複雑に

- 具体的には「カラージッタリングやガウシアンぼかしといった画素値に対してより強い歪みを与えること」や「CutMixという画像の部分的に内容を切り替える技術を利用して画像に通常とは異なる特徴を与えること」などを行った。これにより、様々な視覚知識からロバストな表現をモデルが学習することを可能に。

- auxiliary supervisionを提案

- 他のタスクで事前学習されたエンコーダ(この論文ではDINOv2という手法を使用)から、豊富な意味的な事前知識を継承するためのauxiliary supervisionを提案。これにより、単に深度情報だけでなく、シーンの理解を深める高レベルな特徴をモデルが学習することを可能に。

実際に動かしてみた

実際に動かして試してみた結果を以下にいくつか貼ってみます。

|  |

1つ目、私のプロフィール画像。

なんとなーく合っている?額のあたりがやや手前なのは髪はボリュームがあるものと思っているのかな?

|  |

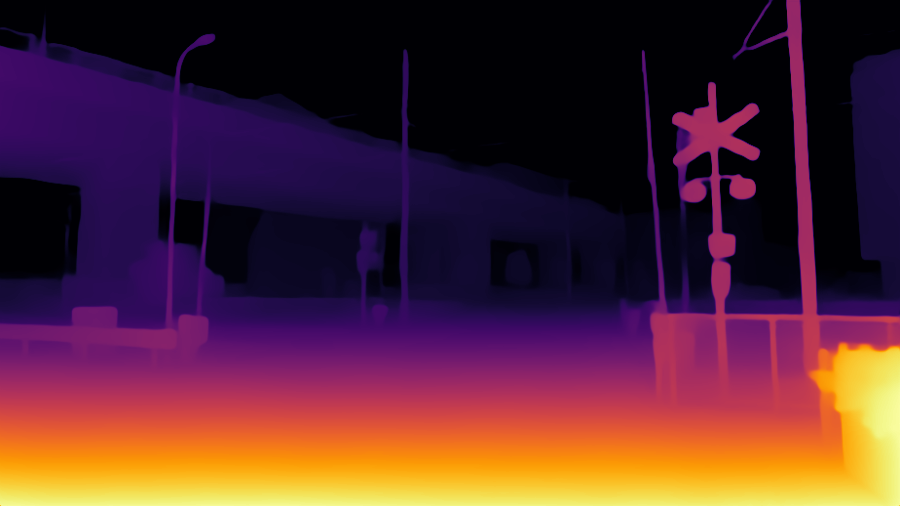

2つ目、風景のイラスト画像。

パッと見かなりそれらしい!ただ、電線とか細すぎるとさすがに厳しいか?いずれにせよ、イラストでもここまでできるのは素晴らしい。

|  |

3つ目、女性の画像。

これもパッと見はかなりそれっぽいですね!髪の毛の隙間はさすがに抜けてないのがやや残念。

まとめ

この記事では「Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data」という論文を紹介しました。

Depth Anythingという手法は、とても乱暴な言い方をすると「モデルや機構云々とかでなく、データでぶん殴ったパワー系の手法」という印象です。

ただ、本記事で紹介下通り、そのデータに対して施している工夫には特筆すべき点があり、その工夫は見習うべき点であると考えます。

実際、論文での結果や私の手元で試してみた結果からみても、Depth Anythingは単眼デプス推定としてかなり優秀な部類であると言えると思います。

デモも公開されていますので、気になる方は是非試してみることオススメします。

というわけで、この記事は説明をここまでとしたいと思います。

それでは。

コメント